IA Gerativa Testada em Receita de Torta de Maçã Manuscrita Apresenta Resultados Mistas

Pontos principais

- Uma receita de torta de maçã manuscrita da família foi dada ao ChatGPT, Gemini e Claude.

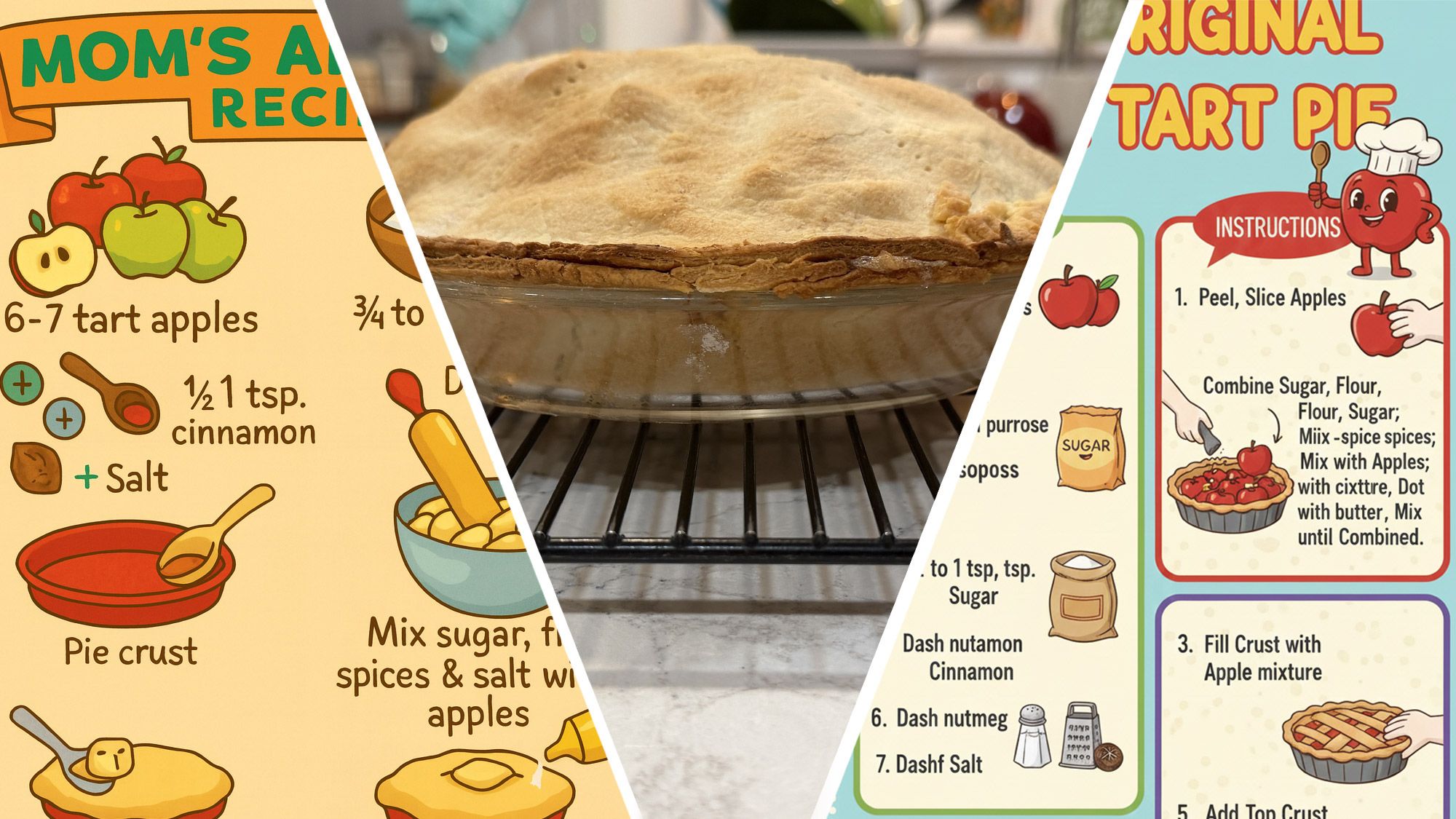

- Todos os modelos produziram infografias visualmente atraentes.

- Gemini e ChatGPT introduziram termos sem sentido e reteram erros de digitação.

- Claude forneceu o texto mais preciso, mas ofereceu pouca arte visual.

- Comandos repetidos melhoraram os resultados apenas marginalmente.

- O experimento destaca a luta da IA com entrada manuscrita imperfeita.

- A revisão humana permanece essencial para saídas práticas e precisas.

Um escritor forneceu uma receita de torta de maçã manuscrita e da família a três principais modelos de IA gerativa - ChatGPT, Gemini e Claude - para ver se eles poderiam transformar as anotações rabiscadas em uma infografia clara e ilustrada. Embora os modelos tenham produzido imagens visualmente atraentes, eles repetidamente leram errado erros de digitação, inventaram itens irrelevantes e não aplicaram lógica culinária básica. O experimento destaca tanto a promessa da criação de conteúdo impulsionada por IA quanto suas limitações atuais ao lidar com entradas imperfeitas e do mundo real.

Visão Geral do Experimento

Um hobbyista decidiu testar as capacidades dos sistemas de IA gerativa mais populares de hoje - ChatGPT, Gemini do Google e Claude da Anthropic - fornecendo-lhes uma receita de torta de maçã manuscrita que havia sido passada de geração em geração na família. As notas originais estavam rabiscadas em um pedaço de papel que também continha texto não relacionado, criando um desafio realista para os modelos de IA. O objetivo era ver se os sistemas poderiam interpretar a caligrafia desordenada, corrigir palavras mal escritas e gerar um guia útil e ilustrado para assar a torta.

Processo e Comandos

O escritor primeiro tentou o Gemini, pedindo que ele convertesse a receita em uma infografia colorida e em estilo de desenho animado, ignorando informações extras na página. Comandos semelhantes foram então enviados ao ChatGPT e ao Claude, cada um com um pedido de instruções claras e arte apropriada. Ao longo do teste, o autor refinou os comandos, dizendo explicitamente aos modelos que usassem palavras reais, evitassem itens sem sentido e se concentrassem nas etapas reais de fazer uma torta.

Descobertas

Todos os três modelos conseguiram produzir gráficos visualmente atraentes, mas cada um tropeçou em diferentes aspectos da tarefa. O Gemini introduziu repetidamente termos estranhos, como "Sprinkle Spitter" e reteve erros de digitação estranhos, como "Dash nutamon", apesar das tentativas de esclarecimento. O modelo também adicionou objetos não relacionados, incluindo um ralador de queijo, que não tinham lugar em uma receita de torta. O ChatGPT gerou uma imagem comparável, mas deixou de fora ferramentas de culinária importantes, como um rolo de massa, e exibiu detalhes sem sentido, como mostarda na torta. O Claude, embora tenha produzido as instruções textuais mais precisas, ofereceu pouco em termos de arte decorativa, resultando em um guia simples, mas funcional.

Questões comuns em todas as tentativas incluíram os modelos de IA lerem errado a caligrafia ilegível, preservarem erros de digitação originais e inventarem itens que nunca foram mencionados no material de origem. Mesmo após várias rodadas de feedback, os modelos muitas vezes reteram palavras erradas, mostrando uma capacidade limitada de aplicar conhecimento específico de domínio - como entender que maçãs inteiras não são colocadas diretamente na crosta da torta.

Implicações

O experimento demonstra que as ferramentas de IA gerativa atuais podem transformar conteúdo bruto e manuscrito em formatos visuais polidos, mas ainda lutam com as nuances de entrada imperfeita. Embora as imagens criadas tenham sido esteticamente agradáveis, as imprecisões nas instruções revelam uma lacuna entre geração superficial e compreensão genuína. Os usuários que buscam saídas confiáveis e sem erros para tarefas práticas podem precisar editar material produzido por IA manualmente, especialmente quando o material de origem contém peculiaridades de caligrafia ou erros tipográficos.

Conclusão

O teste destaca tanto o potencial quanto as limitações atuais da IA ao lidar com dados do mundo real e desordenados. À medida que os modelos de IA continuam a melhorar, sua capacidade de interpretar e refinar anotações manuscritas corretamente provavelmente se tornará mais robusta. Por agora, a tecnologia oferece um ponto de partida útil para projetos criativos, mas ainda requer supervisão humana para garantir precisão e praticidade.