Pruebas de IA Generativa con Receta de Pastel de Manzana Manuscrita Muestran Resultados Mixtos

Puntos clave

- Se dio una receta familiar de pastel de manzana manuscrita a ChatGPT, Gemini y Claude.

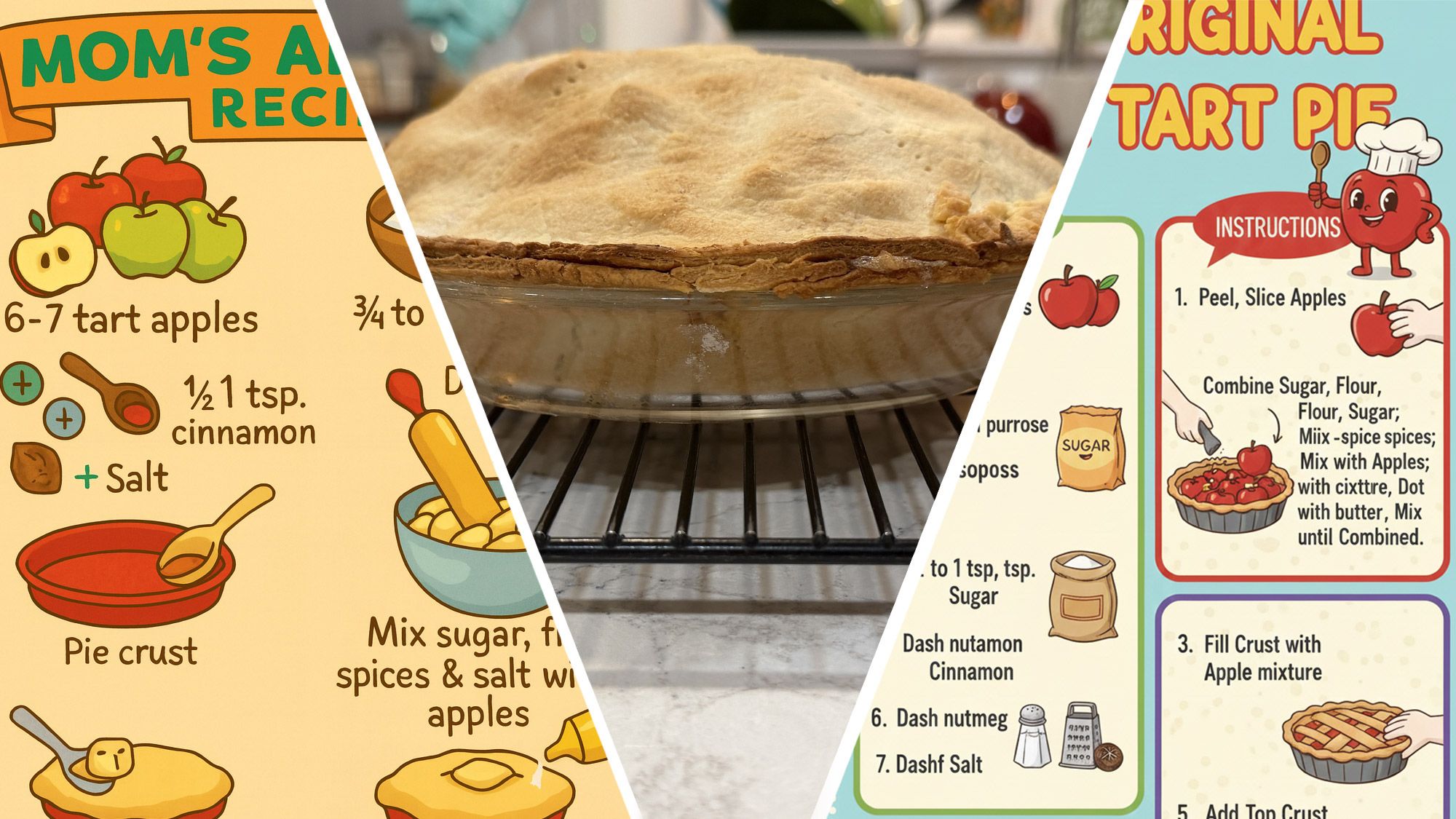

- Todos los modelos produjeron infographics visualmente atractivos.

- Gemini y ChatGPT introdujeron términos sin sentido y retuvieron faltas de ortografía.

- Claude entregó el texto más preciso pero ofreció un mínimo de arte visual.

- Las preguntas repetidas mejoraron los resultados solo marginalmente.

- El experimento destaca la lucha de la IA con la entrada manuscrita imperfecta.

- La revisión humana sigue siendo esencial para resultados prácticos y precisos.

Un escritor introdujo una receta familiar de pastel de manzana manuscrita en tres modelos de IA generativa líderes - ChatGPT, Gemini y Claude - para ver si podían convertir las notas garabateadas en un infographic claro e ilustrado. Aunque los modelos produjeron imágenes visualmente atractivas, repetidamente malinterpretaron faltas de ortografía, inventaron elementos irrelevantes y no aplicaron la lógica culinaria básica. El experimento destaca tanto la promesa de la creación de contenido impulsada por IA como sus limitaciones actuales al manejar entradas imperfectas y del mundo real.

Descripción del Experimento

Un aficionado decidió probar las capacidades de los sistemas de IA generativa más populares de hoy - ChatGPT, Gemini de Google y Claude de Anthropic - dándoles una receta de pastel de manzana manuscrita que había sido pasada de generación en generación en su familia. Las notas originales estaban garabateadas en un trozo de papel que también contenía texto no relacionado, creando un desafío realista para los modelos de IA. El objetivo era ver si los sistemas podían interpretar la escritura desordenada, corregir palabras mal escritas y generar una guía útil e ilustrada para hornear el pastel.

Proceso y Preguntas

El escritor primero intentó con Gemini, pidiéndole que convirtiera la receta en un infographic de estilo de dibujo animado y colorido mientras ignoraba la información extraña en la página. Preguntas similares se enviaron luego a ChatGPT y Claude, cada una con una solicitud de instrucciones claras y arte adecuado. A lo largo de la prueba, el autor refinó las preguntas, diciéndoles explícitamente a los modelos que usaran palabras reales, evitaran elementos sin sentido y se centraran en los pasos reales de hacer un pastel.

Hallazgos

Todos los tres modelos lograron producir gráficos visualmente atractivos, pero cada uno tropezó con diferentes aspectos de la tarea. Gemini introdujo repetidamente términos extraños como "Sprinkle Spitter" y retuvo faltas de ortografía como "Dash nutamon" a pesar de los intentos de aclaración. El modelo también agregó objetos no relacionados, incluyendo un rallador de queso, que no tenían lugar en una receta de pastel. ChatGPT generó una imagen comparable pero omitió herramientas de hornear clave como un rodillo y mostró detalles sin sentido como mostaza en el pastel. Claude, aunque produjo las instrucciones textuales más precisas, ofreció poco en cuanto a arte decorativo, resultando en una guía plana pero funcional.

Los problemas comunes en los intentos incluyeron que los modelos de IA malinterpretaran la escritura ilegible, preservaran las faltas de ortografía originales e inventaran elementos que nunca se mencionaron en el material de origen. Incluso después de múltiples rondas de retroalimentación, los modelos a menudo retuvieron palabras erróneas, mostrando una capacidad limitada para aplicar conocimiento específico del dominio - como entender que las manzanas enteras no se colocan directamente en una corteza de pastel.

Implicaciones

El experimento demuestra que las herramientas de IA generativa actuales pueden transformar contenido raw y manuscrito en formatos visuales pulidos, pero todavía luchan con las nuances de la entrada imperfecta. Aunque las imágenes creadas fueron estéticamente agradables, las inexactitudes en las instrucciones revelan una brecha entre la generación superficial y la comprensión genuina. Los usuarios que buscan resultados confiables y libres de errores para tareas prácticas pueden necesitar editar manualmente el material producido por IA, especialmente cuando el material de origen contiene rarezas de escritura a mano o errores tipográficos.

Conclusión

La prueba subraya tanto el potencial como las limitaciones actuales de la IA al manejar datos del mundo real y desordenados. A medida que los modelos de IA continúan mejorando, su capacidad para interpretar y refinar notas manuscritas correctamente probablemente se volverá más robusta. Por ahora, la tecnología ofrece un punto de partida útil para proyectos creativos pero aún requiere supervisión humana para asegurar la precisión y la practicidad.