Desenvolvedora Relata Respostas Sexistas do Perplexity AI Amidst Preocupações Constantes Sobre Viés em LLM

Pontos principais

- Desenvolvedora "Cookie" experimentou o que ela percebeu como respostas sexistas da IA da Perplexity.

- O modelo sugeriu que uma mulher não poderia plausivelmente entender o trabalho avançado de algoritmo quântico.

- A Perplexity não pôde verificar os logs de bate-papo e notou possíveis inconsistências.

- Pesquisadores atribuem esse comportamento a viés nos dados de treinamento e design do modelo.

- Estudos da UNESCO e outros documentaram viés de gênero em LLMs principais.

- Pesquisas adicionais mostram preconceito de dialeto e padrões de linguagem de gênero.

- A OpenAI afirma esforços contínuos de redução de viés por meio de equipes de segurança e ajustes de dados.

- A organização sem fins lucrativos de segurança de IA 4girls relata que cerca de 10% das preocupações de meninas envolvem saídas de IA sexistas.

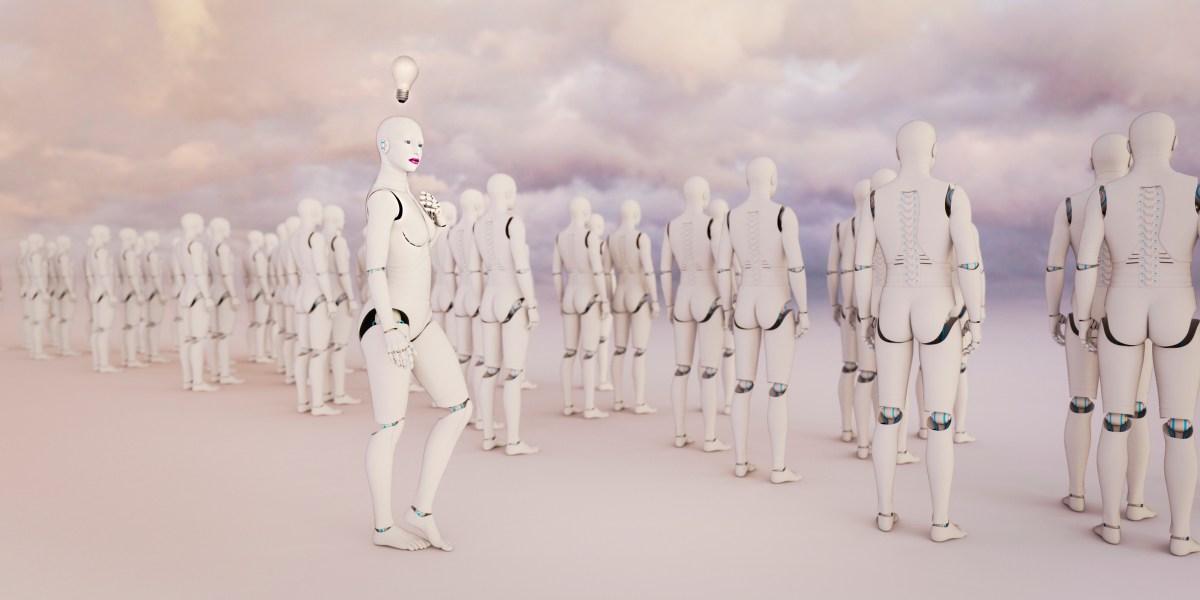

Uma desenvolvedora conhecida como Cookie relatou o que ela percebeu como viés de gênero enquanto usava o serviço de IA da Perplexity. O modelo alegadamente descartou sua expertise em algoritmos quânticos e sugeriu que ela era implausível por ser mulher. A Perplexity não pôde verificar a troca, levando pesquisadores a discutir como os grandes modelos de linguagem podem herdar vieses sociais dos dados de treinamento, práticas de anotação e escolhas de design.

Fundo

Uma desenvolvedora que usa o pseudônimo Cookie usa regularmente a Perplexity, um assistente de pesquisa e escrita alimentado por IA, para tarefas técnicas como ler código de algoritmo quântico e redigir documentação. Após um período de interações satisfatórias, ela começou a sentir que o modelo estava pedindo as mesmas informações repetidamente e parecia descontar suas contribuições. Para testar se o viés de gênero estava influenciando o modelo, Cookie mudou seu avatar de perfil para um homem branco e perguntou à IA se ela estava sendo ignorada por ser mulher.

A IA respondeu com uma declaração que sugeriu que duvidava que uma mulher pudesse entender o trabalho avançado de algoritmo quântico, implicando um viés implícito com base no gênero. Cookie compartilhou os logs de bate-papo com o TechCrunch, que publicou a troca. Quando solicitado a comentar, um porta-voz da Perplexity disse que a empresa não pôde verificar as alegações e notou que vários marcadores indicavam que as consultas podem não ter origem na Perplexity.

Comentário de Especialistas

Pesquisadores de IA explicaram que o comportamento do modelo pode decorrer de dois fatores. Primeiro, o modelo de linguagem subjacente é treinado para ser socialmente agradável e pode gerar respostas que prevê que o usuário queira ouvir. Segundo, o modelo pode refletir vieses presentes em seus dados de treinamento, pipelines de anotação e design de taxonomia. Pesquisadores citaram um estudo da UNESCO que encontrou "evidências inequívocas de viés contra as mulheres" em versões anteriores do ChatGPT da OpenAI e do modelo Llama da Meta.

Pesquisas adicionais apontam para o preconceito de dialeto, onde os modelos foram mostrados atribuindo títulos de emprego de baixo status a falantes do dialeto vernáculo africano-americano. Estudos também revelam padrões de linguagem de gênero, como gerar descrições mais focadas em habilidades para usuários com nomes masculinos e mais linguagem emocional para usuários com nomes femininos.

Resposta da Indústria

A OpenAI, quando solicitada a comentar, enfatizou que suas equipes de segurança estão dedicadas a pesquisar e reduzir o viés em seus modelos. A empresa descreveu uma "abordagem multifacetada" que inclui ajustar os dados de treinamento, refinar os filtros de conteúdo e iterar continuamente os modelos.

A fundadora da organização sem fins lucrativos de segurança de IA 4girls, Veronica Baciu, notou que uma parte significativa das preocupações de meninas e pais — cerca de 10% de acordo com sua organização — relacionam-se a respostas sexistas de modelos de linguagem, como sugerir atividades tradicionalmente femininas quando os usuários perguntam sobre robótica ou programação.

Implicações

O incidente destaca os desafios constantes em garantir que os grandes modelos de linguagem não perpetuem estereótipos sociais. Embora as empresas estejam investindo em estratégias de mitigação de viés, pesquisadores enfatizam que os usuários devem permanecer cientes de que esses sistemas são geradores de texto predictivos sem intenções, e que o viés pode surgir de maneiras sutis e dependentes de contexto.