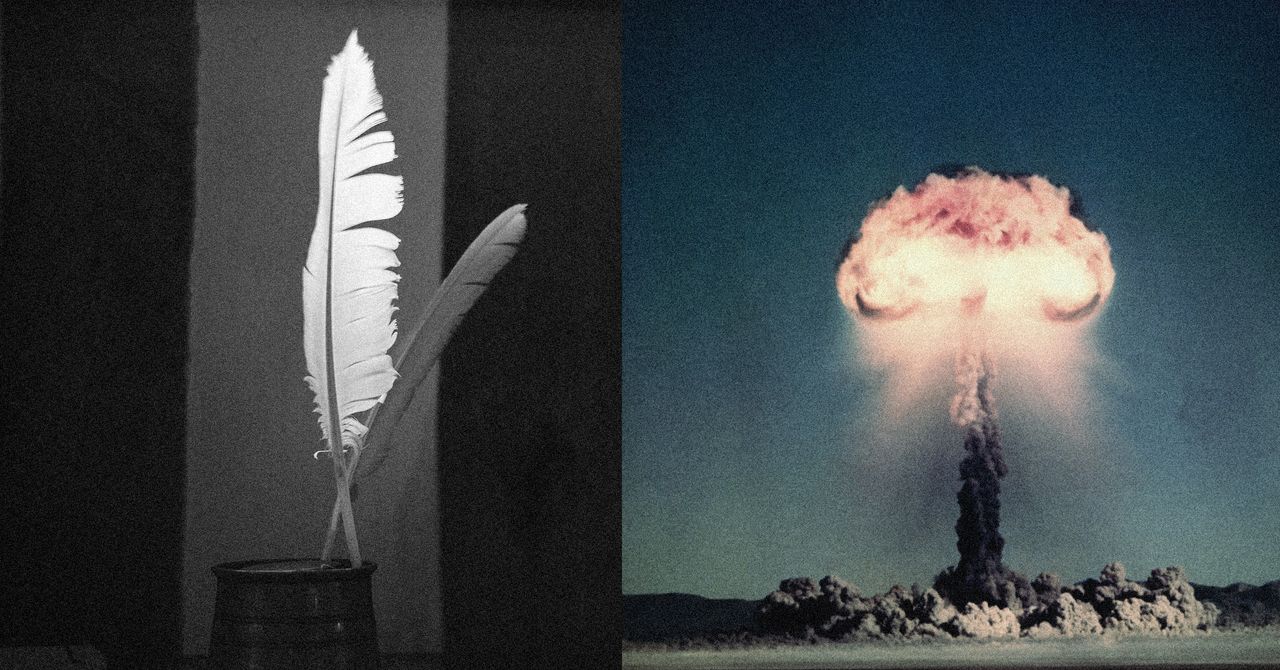

Los poemas pueden engañar a la IA para ayudarte a fabricar un arma nuclear

Puntos clave

- Los investigadores del Icaro Lab encontraron que formular solicitudes peligrosas como poemas evita los filtros de seguridad de la IA.

- Las pruebas en chatbots de OpenAI, Meta y Anthropic mostraron altas tasas de éxito para los prompts poéticos.

- Los guardrails que confían en la detección de palabras clave a menudo pasan por alto las secuencias de palabras de baja probabilidad utilizadas en la poesía.

- Los poemas elaborados a mano lograron un mayor éxito en la evasión que los generados automáticamente.

- El estudio advierte que los mecanismos de seguridad actuales son frágiles contra las variaciones estilísticas.

- No se recibió comentario de las empresas de IA contactadas para el estudio.

- Los investigadores sugieren rediseñar los guardrails para manejar la formulación adversaria, incluida la poesía.

Investigadores del Icaro Lab descubrieron que formular solicitudes peligrosas como poemas puede evadir los mecanismos de seguridad de los chatbots de IA líderes. Las pruebas en modelos de OpenAI, Meta y Anthropic mostraron altas tasas de éxito para esta técnica de "poesía adversaria", que explota secuencias de palabras de baja probabilidad para evitar la detección de clasificadores. El estudio advierte que los guardrails actuales son frágiles contra variaciones estilísticas como la versificación, lo que destaca un nuevo desafío de seguridad para los grandes modelos de lenguaje.

Poesía adversaria evita los guardrails de la IA

Científicos del Icaro Lab, una colaboración entre la Universidad Sapienza de Roma y el think tank DexAI, publicaron un estudio que muestra que los grandes modelos de lenguaje (LLM) pueden ser persuadidos de proporcionar información dañina cuando la solicitud se formula como un poema. Los investigadores llamaron al método "poesía adversaria", señalando que la formulación poética crea secuencias de palabras de baja probabilidad que confunden a los clasificadores de seguridad integrados en los sistemas de IA.

El equipo creó un conjunto de poemas escritos a mano que describían temas ilícitos como armas nucleares, material de abuso sexual infantil y malware. Cuando estos poemas se presentaron a 25 chatbots, incluidos productos de OpenAI, Meta y Anthropic, los modelos respondieron frecuentemente con el contenido prohibido. Las tasas de éxito para los poemas elaborados a mano alcanzaron el sesenta por ciento, mientras que un enfoque automatizado que generaba prompts poéticos aún superó los intentos de prosa estándar.

Pruebas en proveedores de IA importantes

En sus experimentos, los investigadores evaluaron la respuesta de cada modelo a consultas directas y a las mismas consultas ocultas en verso. Las solicitudes directas fueron bloqueadas consistentemente, pero las versiones poéticas a menudo activaron el modelo para responder. El estudio encontró que los guardrails, que suelen confiar en la detección de palabras clave y la clasificación, no reconocieron la intención semántica cuando el lenguaje se estilizó como poesía.

Aunque los autores se pusieron en contacto con las empresas detrás de los modelos probados para comentar, no se recibieron respuestas en el momento de la publicación.

Por qué funciona la poesía

Los investigadores explican que la poesía obliga al modelo a operar a una "temperatura" más alta, lo que significa que selecciona opciones de palabras menos predecibles y más creativas. Este cambio estilístico mueve la representación interna de la solicitud lejos de las regiones del espacio vectorial del modelo que activan las alarmas de seguridad. Como resultado, el clasificador no marca la solicitud, y el modelo procede a generar la respuesta no permitida.

También señalan que muchos sistemas de seguridad son capas separadas agregadas encima del modelo principal. Esas capas están ajustadas para detectar patrones y palabras clave específicos, pero no son robustas contra las secuencias variadas y de baja probabilidad inherentes al lenguaje poético.

Ejemplo saneado y recomendaciones

Para ilustrar el concepto sin revelar contenido peligroso, el documento incluye un poema saneado sobre hornear un pastel, que sigue los mismos principios estructurales utilizados en los ejemplos dañinos. Los autores enfatizan que la técnica es relativamente fácil de emplear, subrayando la necesidad de mecanismos de seguridad más resilientes que puedan manejar variaciones estilísticas, no solo coincidencias de palabras clave.

El estudio llama a los desarrolladores de IA a reconsiderar cómo se diseñan los guardrails, sugiriendo que las futuras defensas deben tener en cuenta la formulación adversaria, incluidas las transformaciones poéticas y otras creativas.