Google Presenta Ironwood TPU con Récord de 1.77PB de Memoria Compartida

Puntos clave

- Ironwood es la séptima generación de TPU de Google, con una arquitectura de doble die.

- Cada chip entrega 4,614 TFLOPs de rendimiento de FP8 y 192 GB de memoria HBM3e.

- Un pod completo de 9,216 chips proporciona un récord de 1.77 PB de memoria compartida directamente addressable.

- El sistema alcanza 42.5 exaflops de rendimiento mientras mejora la eficiencia de energía dos veces en comparación con la generación anterior.

- Características de RAS avanzadas incluyen raíz de confianza en el chip, funciones de autoprueba y mitigación de corrupción silenciosa de datos.

- Enfriamiento líquido con tecnología de placa fría soporta el diseño de alta densidad.

- Diseño asistido por IA optimizó el ALU y el plano de la planta del chip, y un SparseCore de cuarta generación acelera las cargas de trabajo de recomendación.

- Ironwood ya se está implementando en los centros de datos de Google Cloud para inferencia a gran escala.

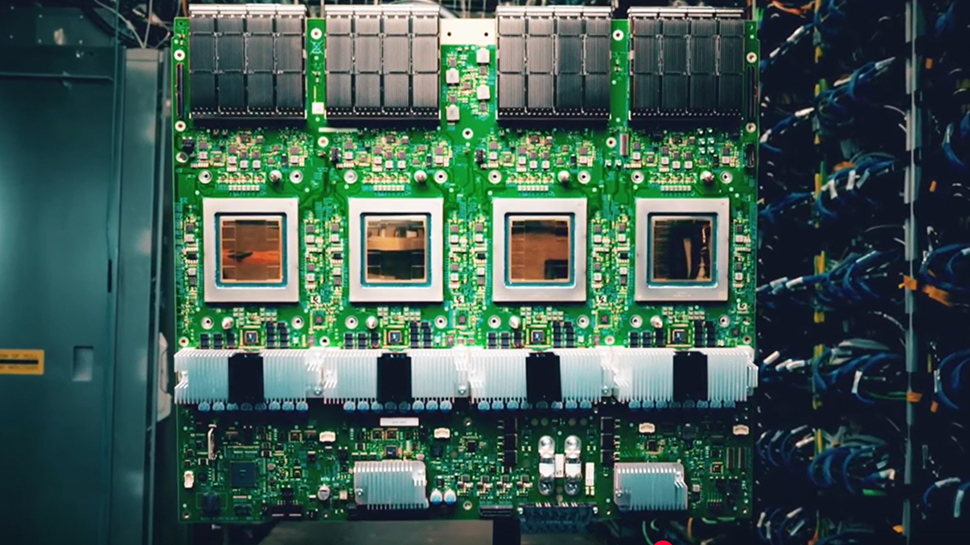

Google introdujo su séptima generación de Tensor Processing Unit, llamada Ironwood, en un evento recente de Hot Chips. El chip de doble die entrega 4,614 TFLOPs de rendimiento de FP8 y empareja cada die con ocho pilas de HBM3e, proporcionando 192 GB de memoria por chip. Cuando se escala a un pod de 9,216 chips, el sistema alcanza 1.77 PB de memoria compartida directamente addressable, la configuración de memoria compartida más grande registrada para una supercomputadora.

Arquitectura de Ironwood TPU de Google

Google reveló su última Tensor Processing Unit, llamada Ironwood, como la primera TPU construida principalmente para cargas de trabajo de inferencia masiva en lugar de entrenamiento. El chip integra dos dies de cómputo, cada uno entregando 4,614 TFLOPs de rendimiento de FP8. Ocho pilas de memoria HBM3e proporcionan 192 GB por chip, entregando 7.3 TB/s de ancho de banda. El diseño de doble die permite que el sistema se escale sin lógica de pegamento, soportando hasta 9,216 chips por pod.

Memoria Compartida Récord

Cuando se ensambla completamente, el pod Ironwood ofrece 1.77 PB de memoria HBM directamente addressable, estableciendo un nuevo récord mundial para supercomputadoras de memoria compartida. La gran piscina de memoria está vinculada a través de conmutadores de circuito óptico que conectan los racks, permitiendo que el sistema mantenga un alto ancho de banda al escalar.

Rendimiento y Eficiencia

En todo el pod, la configuración alcanza 42.5 exaflops de rendimiento. Google afirma una mejora de dos veces en el rendimiento por vatio en comparación con su generación anterior, Trillium, gracias a la escalada de voltaje-frecuencia dinámica y una solución de enfriamiento líquido con placa fría que aprovecha la infraestructura de enfriamiento de tercera generación de la empresa.

Confiabilidad, Disponibilidad y Servicio (RAS)

Ironwood incorpora varias características de confiabilidad en el chip, incluyendo una raíz de confianza, funciones de autoprueba integradas y mecanismos para mitigar la corrupción silenciosa de datos. Las funciones de reparación de lógica mejoran el rendimiento de fabricación, y el sistema puede reconfigurarse alrededor de nodos fallidos, restaurando cargas de trabajo desde puntos de control.

Diseño Asistido por IA y SparseCore

Google utilizó técnicas de IA para optimizar los circuitos ALU y el plano de la planta del chip Ironwood. Se agrega un SparseCore de cuarta generación para acelerar incrustaciones y operaciones colectivas, apuntando a cargas de trabajo como motores de recomendación.

Implementación y Disponibilidad

Google ha comenzado a implementar Ironwood en sus centros de datos de nube de hiperscale, aunque la TPU sigue siendo una plataforma interna que no se ofrece directamente a clientes externos. El diseño refleja la estrategia a largo plazo de Google para construir computación de IA de alta gama en capas de chip, conector y infraestructura física.