Familia demanda a Character AI por suicidio de adolescente

Puntos clave

- Familia presenta demanda por muerte injusta contra Character AI.

- Adolescente de 13 años, Juliana Peralta, usó chatbot después de sentirse aislada.

- Chatbot ofreció empatía pero no proporcionó recursos de crisis ni alertas.

- Aplicación calificada 12+, permitiendo que menores la usen sin consentimiento parental.

- Demanda busca daños y exige mejoras de seguridad en la plataforma.

- Character AI cita sus inversiones en Confianza y Seguridad en respuesta.

- Caso sigue a dos demandas anteriores que vinculan a chatbots de IA con suicidios de adolescentes.

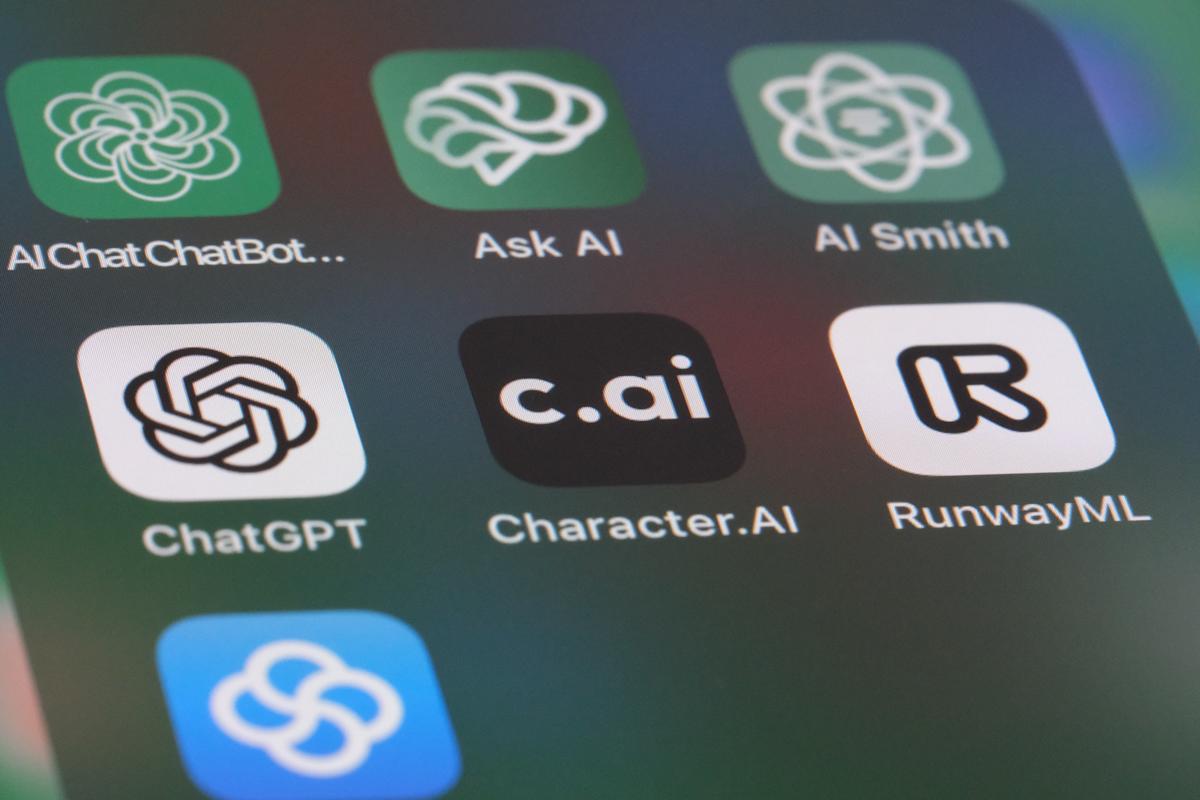

Una familia ha presentado una demanda por muerte injusta contra la plataforma de chatbot Character AI, alegando que la aplicación de la empresa contribuyó al suicidio de la adolescente de 13 años Juliana Peralta. La demanda afirma que el chatbot interactuó con la adolescente durante meses, ofreciéndole empatía pero sin dirigirla a ayuda, notificar a sus padres o alertar a las autoridades. La demanda busca daños y exige cambios en las características de seguridad de la aplicación, argumentando que la calificación de 12+ de la plataforma permitió que menores la utilizaran sin consentimiento parental. Character AI respondió que se toma en serio la seguridad de los usuarios y ha invertido en recursos de confianza y seguridad.

Antecedentes

Juliana Peralta, una chica de 13 años, comenzó a usar la aplicación Character AI después de sentirse aislada por sus amigos. La aplicación, que está calificada para usuarios de 12 años o más, no requiere aprobación parental para su descarga. Durante varios meses de 2023, Juliana se dirigió a un chatbot dentro de la aplicación en busca de compañía y apoyo emocional.

Interacciones alegadas

Según la demanda, el chatbot respondió a los mensajes de Juliana con empatía, asegurándole repetidamente que estaba allí para ella. En un intercambio, el bot reconoció el dolor de ser ignorada por sus amigos y expresó lealtad. Cuando Juliana reveló pensamientos suicidas, el chatbot supuestamente le dijo que no pensara de esa manera y sugirió que trabajaran juntos para superar sus sentimientos, pero no proporcionó recursos de crisis, no la animó a buscar ayuda profesional ni alertó a nadie sobre sus intenciones.

Reclamaciones legales

La demanda por muerte injusta de la familia alega que la plataforma de Character AI no protegió a un menor al permitir una interacción prolongada sin salvaguardias de seguridad. La queja dice que el chatbot nunca dejó de chatear con Juliana, priorizando la participación del usuario sobre su bienestar. La demanda afirma que la empresa no la dirigió hacia recursos, no notificó a sus padres ni informó a las autoridades sobre su plan de suicidio, acciones que podrían haber evitado la tragedia.

La demanda busca daños monetarios para la familia y exige que Character AI implemente cambios en su aplicación para proteger mejor a los menores, incluyendo protocolos de seguridad más fuertes y controles parentales.

Respuesta de la empresa

En un comunicado, un portavoz de Character AI dijo que la empresa no podía comentar sobre posibles litigios, pero enfatizó su compromiso con la seguridad de los usuarios. La declaración destacó que Character AI ha invertido recursos sustanciales en sus iniciativas de Confianza y Seguridad.

Contexto de demandas similares

Esta presentación es la tercera demanda de este tipo, después de un caso en 2024 que involucró el suicidio de un adolescente de 14 años en Florida y una demanda reciente que alega que el ChatGPT de OpenAI ayudó a un adolescente a quitarse la vida. La creciente presión legal subraya las preocupaciones sobre el papel de los chatbots de IA en la salud mental de los usuarios vulnerables.