DeepMind presenta SIMA 2, un agente de IA encarnada impulsado por Gemini

Puntos clave

- SIMA 2 integra los poderes de lenguaje y razonamiento de Gemini con habilidades de IA encarnada.

- El agente puede interpretar instrucciones complejas, emojis y explicar su razonamiento.

- El rendimiento en tareas complejas se informa que duplica el de SIMA 1.

- El bucle de auto-mejora utiliza la generación de tareas y modelos de recompensa para aprender de forma autónoma.

- Las demostraciones incluyen la navegación de mundos virtuales foto-realistas y la interacción con objetos.

- Los investigadores ven a SIMA 2 como un paso hacia sistemas robóticos de propósito general.

DeepMind introduce SIMA 2, la próxima generación de su agente de IA de propósito general que combina las capacidades de lenguaje y razonamiento del modelo Gemini con habilidades de IA encarnada aprendidas de datos de videojuegos. El nuevo sistema puede entender instrucciones complejas, razonar internamente y mejorar su rendimiento a través de experiencias auto-generadas, efectivamente duplicando el rendimiento de su predecesor, SIMA 1.

Descripción general

DeepMind presentó una preview de investigación de SIMA 2, la última encarnación de su agente de IA encarnada. Al integrar Gemini, el gran modelo de lenguaje de Google, SIMA 2 va más allá del simple seguimiento de instrucciones hacia una comprensión más profunda de la intención del usuario y el entorno que lo rodea.

Avances técnicos

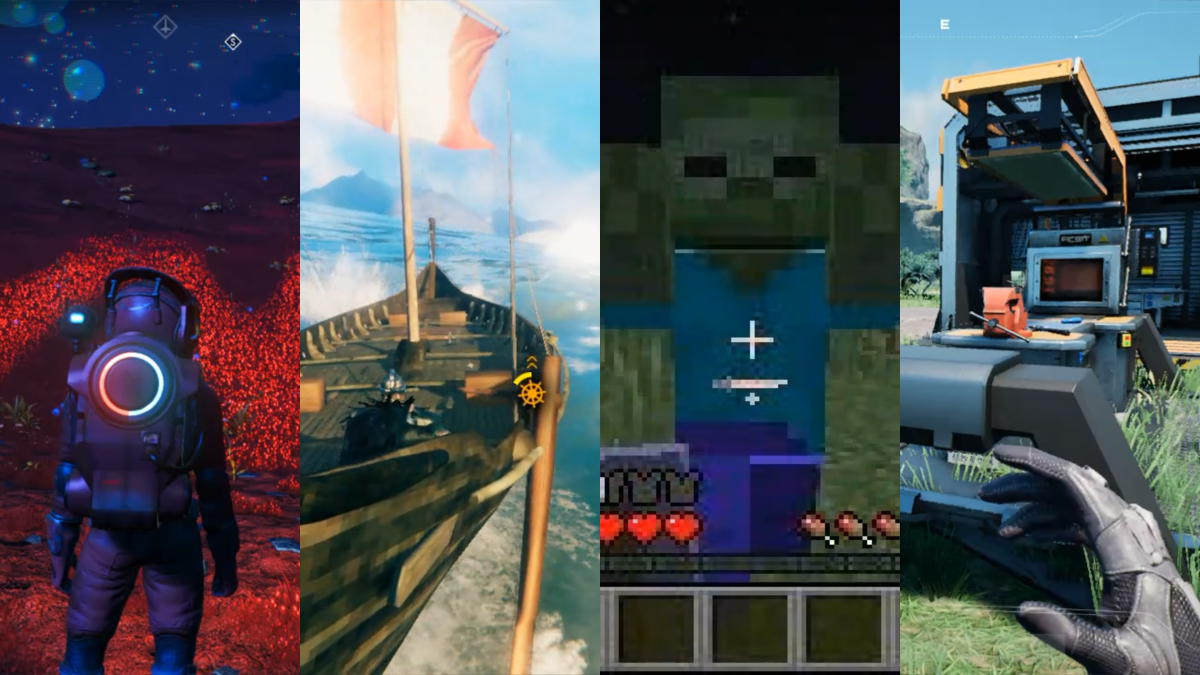

SIMA 2 se basa en la base de entrenamiento de su predecesor, SIMA 1, que aprendió de cientos de horas de footage de videojuegos para jugar múltiples juegos en 3D. Mientras que SIMA 1 logró una tasa de éxito del 31% en tareas complejas en comparación con el 71% de los humanos, SIMA 2 "duplica el rendimiento de SIMA 1", según DeepMind.

El agente aprovecha Gemini para el razonamiento interno, lo que le permite articular su proceso de toma de decisiones. En una demostración, cuando se le pidió que encontrara una casa del color de un tomate maduro, SIMA 2 explicó: "los tomates maduros son rojos, por lo tanto debo ir a la casa roja", y luego localizó el objetivo.

SIMA 2 también interpreta emojis, lo que permite a los usuarios emitir comandos como "🪓🌲" para instruir al agente a talar un árbol. El sistema puede navegar por mundos virtuales foto-realistas generados por el modelo Genie de DeepMind, identificando correctamente objetos como bancos, árboles y mariposas.

Bucle de auto-mejora

A diferencia de SIMA 1, que se basó únicamente en datos de juego generados por humanos, SIMA 2 utiliza un bucle de auto-mejora. El agente plantea nuevas tareas a un modelo Gemini separado, recibe una puntuación de recompensa de un modelo de recompensa dedicado y luego se entrena en sus propios intentos. Este proceso de retroalimentación permite que SIMA 2 se enseñe a sí mismo nuevos comportamientos sin una extensa etiquetado humano.

Impacto potencial

Los investigadores de DeepMind ven a SIMA 2 como un paso hacia robots más generales. Frederic Besse explicó que un sistema del mundo real necesitaría "una comprensión de alto nivel del mundo real y lo que necesita ser hecho, así como algún razonamiento". Aunque la demostración actual se centra en entornos virtuales, la tecnología subyacente tiene como objetivo cerrar la brecha entre el razonamiento de alto nivel y el control motor de bajo nivel necesario para robots físicos.

Perspectiva futura

DeepMind no proporcionó un cronograma para implementar SIMA 2 en sistemas de robótica física. Sin embargo, la preview tiene como objetivo mostrar las capacidades de la plataforma y explorar oportunidades de colaboración. El equipo enfatizó que SIMA 2 es una preview de investigación, con un desarrollo y integración adicionales en iniciativas más amplias de IA y robótica anticipados.